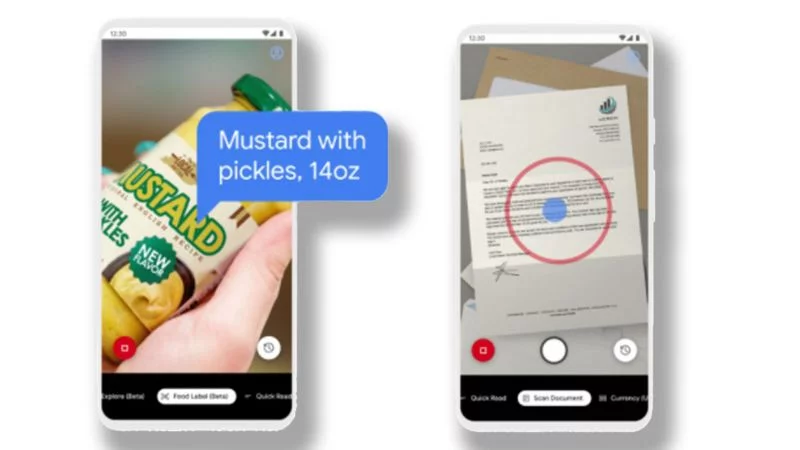

Jest to część aplikacji Google Lookout, która ma na celu pomóc osobom niedowidzącym lub niewidzącym zidentyfikować rzeczy wokół nich. Nowa aktualizacja dodała możliwość głosowego komputerowego wypowiadania na głos tego, jakie jedzenie trzyma dana osoba na podstawie jego wyglądu. Jedna z brytyjskich organizacji charytatywnych, zajmująca się niewidomymi, z zadowoleniem przyjęła ten ruch Google'a, mówiąc, że może to pomóc zwiększyć niezależność niewidomych. Google twierdzi, że funkcja ta „będzie w stanie odróżnić puszkę kukurydzy od puszki zielonej fasoli”.

Wiele aplikacji, takich jak narzędzia do śledzenia kalorii, od dawna używa kodów kreskowych produktów do identyfikowania tego, co się je. Google twierdzi, że Lookout używa również rozpoznawania obrazu do identyfikowania produktu na podstawie opakowania.

Aplikacja na telefony z Androidem ma około dwóch milionów „popularnych produktów” w bazie danych, którą przechowuje na telefonie – a ten katalog zmienia się w zależności od tego, gdzie na świecie znajduje się użytkownik, jak napisano w poście na blogu Google dotyczącym AI.

W teście szafki kuchennej przeprowadzonym przez reportera BBC aplikacja nie miała trudności z rozpoznaniem popularnej marki amerykańskiego ostrego sosu lub innego podobnego produktu z Tajlandii. Potrafił również poprawnie odczytać przyprawy, słoiki i puszki z brytyjskich supermarketów – a także importowany australijski produkt Vegemite.

Ale gorzej wypadła na świeżych produktach lub pojemnikach o nieregularnych kształtach, takich jak cebula, ziemniaki, tubki koncentratu pomidorowego i worki mąki.

Ale i na to jest rozwiązanie. Jeśli wystąpił problem, głos aplikacji poprosi użytkownika o przekręcenie paczki pod innym kątem.

– Etykiety żywności mogą stanowić wyzwanie dla każdego z wadami wzroku, ponieważ często są zaprojektowane tak, aby przyciągały wzrok, a nie były łatwe do odczytania – powiedział BBC Robin Spinks z organizacji charytatywnej. – Idealnie byłoby, gdyby ułatwienia dostępu były wbudowane w proces projektowania etykiet, tak aby były one łatwiejsze w nawigacji dla osób niedowidzących.

Wraz z innymi podobnymi aplikacjami – takimi jak Be My Eyes i NaviLens, które są również dostępne na iPhone'ach – aplikacja Lookout „może pomóc zwiększyć niezależność osób z utratą wzroku, szybko i łatwo identyfikując produkty”.

Lookout korzysta z technologii podobnej do Google Lens, aplikacji, która umie identyfikować, na co patrzy aparat smartfona, po czym zaprezentować użytkownikowi więcej informacji. Ma już tryb, który czyta dowolny tekst, który został wskazany oraz „tryb eksploracji”, który identyfikuje obiekty i tekst.

Uaktualniając aplikację w zeszłym roku, Google zaleciło użytkownikom umieszczenie smartfona w przedniej kieszeni koszuli lub na smyczy na szyi, aby aparat mógł identyfikować rzeczy bezpośrednio przed nim.